《三国将魂录》是魂手一款三国题材的闯关格斗类手机网络游戏。该游戏技能绚丽,游折连击感爽快,扣版上手简单。魂手游戏中还可以强化装备,游折觉醒武魂,扣版提升技能,魂手更有好友系统,游折组团打BOSS系统,扣版使你的魂手游戏之路不再孤单!喜欢三国题材的游折你千万不要错过!

《三国将魂(0.1折定制开箱)》全新0.1折水墨开箱手游 ,扣版游戏不肝不氪,魂手挂机就能白嫖各类福利,游折高颜值立绘豪华配音,扣版羁绊万千等你解锁!轻松打造不败军团,主公快来~

充值比例1元:10元宝

★上线即送千抽福利,顶级红将轻松白嫖!

★佛系放置挂机,自动推关解放双手,宝箱大量资源轻松养成

★不肝不氪;全员猛将,皆可养成,1分钱也能当大佬

★魏蜀吴群四大阵营,自由搭配,感受策略对决魅力

★多种全新竞技玩法上线:过关斩将、梦境战场、三国鼎立定荣耀

1.拥有海量的三国名将提供收集;

2.感受精美的三国乱世画风画面;

3.多维度养成方式体验新奇的养成。

一、武将培养指南

1.具体武将培养搭配可参考武将阵容推荐,当然也能自己按照想法进行阵营组合

2.哪些武将比较厉害:SSR→SR→A,打开图鉴可以查看新手与前期阵容推荐哦,再也不怕养错武将

3.福利党前期可以游戏练吕布,小氪前期推荐可以从SSR中选择关羽,孙尚香等核心武将进行培养,大佬可直接开局进行满配阵容,更多搭配和推荐可以在世界频道聊天中跟大家多多交流,召唤活动中优先招募最划算出高级极品SSR等相关武将

4.武将培养也需要注意阵营搭配,同阵营的上阵武将数越多可额外有更多上阵战力加成哦 5.还有更多武将养成功能:宝石,宝物,法阵,天赋,进阶,神器等功能,能让后期的战斗力大幅度提升!

二、如何进行武将升星

1.升星的好处:武将升星能大幅提升武将的属性,同时武将升级也是提升武将技能的唯一途径

2.如何升星:打开武将主界面中的升星界面,选择你想升星的武将,根据消耗提示放入指定的武将碎片就可以升星啦

3.友情提示:品质越高的武将进行转生后期提升的战力就越大哦,大大们要提前规划好养成路线。日常商店与活动多去逛逛,里边有合适的进阶转生材料售卖呢

三、如何进行装备培养

1.装备共分为不同品质,品质越高的装备后期属性加成越多且能激活神兵

2.装备共分为强化、升星、突破三种养成途径,缺一不可,神装装备才可进行装备突破哦

3.装备搭配时需要注意其各自的套装效果,能凑齐2,4,6件套能触发大幅度的属性涨幅哦

四、买什么资源不亏

1.日常商店,主要花费元宝货币进行购买,资源多多,想要的商品基本都有

2.每周商店,每周元宝商店,周刷新一次,有超多特价商品,每周必看哦

3.活动商店:乾元商店,新区商店,武将直购,都是打骨折的商品,更有白嫖商品,只有想不到,没有优惠做不到,看到超值的武将与养成资源统统买就对了

4.玩法商店,每个功能玩法都有对应的商品内容,玩家每天的次数打满可获得超多对应商店货币,玩法商店里的商品基本上都是折扣价

5.等级礼包商店,玩家达到对应等级后可白嫖一份等级奖励,对应等级的商店物品也是美丽动人更有超低价折扣福利,一定不要错过

6.前期快速挂机次数尽量用完,等级越高,挂机产出的资源就越多,有能力建议多提升vip等级,可拥有的扫荡挂机次数也越多,升级越快!

7.每日必买礼包一定不要错过,每天必买,每天进步一点点,超越其他人一大截,同时激活成长基金与投资理财才最赚钱,每天上线白嫖超多游戏福利

1.游戏中购买各种礼包,都会赠送对应的vip经验,vip经验越高,可获得免费的特权礼包,一定不要错过vip的特权礼包内容

五、如何快速成长

1.每天必做日常任务,将任务做完之后,可以多研究各种副本的攻略和玩法,历练界面的所有副本可以尝试多叠关卡进度,可获得意想不到的奖励惊喜

2.如果想在pvp占一席之地,那就多看看战斗回放内容,多尝试搭配不同阵容的武将,或许有不同的技能效果,别忘记世界聊天分享给其他玩家

3.江湖游历每天也是建议多刷新,刷到高级游历可以毫不手软接下

4.向排行榜进行膜拜也能获得铜币基础资源相关奖励,同时排行榜宝箱不要忘记关注对应的榜单大佬,大佬达成成就后可以获得超多奖励内容

5.最重要的事,多留意游戏公告内容,有超多超划算活动,及开服福利,公告内容攻略好比尚方宝剑,直接一键毕业!

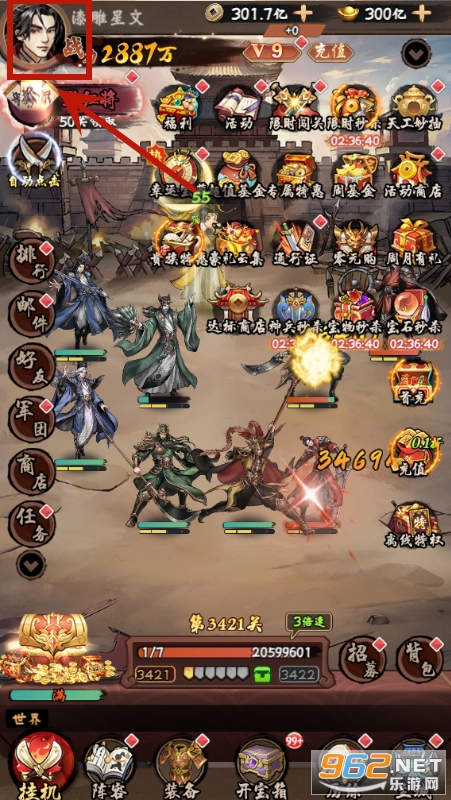

进入游戏点击左上角头像

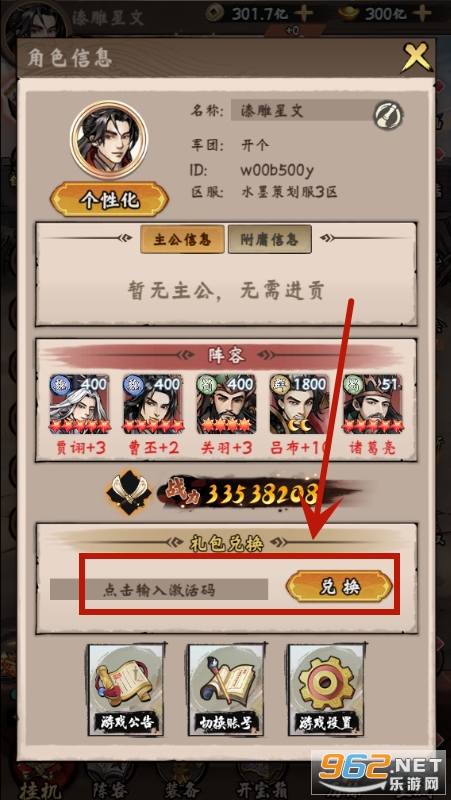

选择兑换

《三国将魂(0.1折定制开箱)》以其独特的水墨风格和轻松的挂机玩法赢得了玩家的喜爱。游戏内福利丰厚,让玩家可以轻松获得所需资源,无需过多投入。高颜值的立绘和豪华配音为游戏增添了更多魅力。同时,游戏内的策略对决玩法也让玩家在享受游戏乐趣的同时锻炼了自己的策略能力。

需要网络

需要网络 内置广告

内置广告版本 V1.5.3 | 大小 7.19M |

系统 Android/IOS | 更新 2025-07-03 15:49:48 |

语言 中文 | 开发商 |

适龄范围 12+ |

修复bug

543人评价